ChatGPT开启医学革命新篇章:昆士兰大学发现其助力前列腺癌诊断,为患者赋能带来新希望!

| 导读 | 人工智能可以通过教育,为前列腺癌诊断后的患者赋能。 |

2024年6月24日,澳大利亚皇家布里斯班妇女医院泌尿外科Harry Collin团队在期刊《Prostate Cancer and Prostatic Diseases》上发表了题为“ChatGPT can help guide and empower patients after prostate cancer diagnosis”的研究论文。该团队使用ChatGPT来生成,新诊断患者可能会搜索的有关前列腺癌的问题,并与Google搜索趋势进行了比较。随后,该团队使用标准化工具,评估了ChatGPT对这些问题的回答的临床适用性和质量。

https://www.nature.com/articles/s41391-024-00864-6

研究背景

01

患者经常对自己的健康问题,进行自我教育,特别是当焦虑影响信息理解时。基于网络的信息(如YouTube、TikTok、Instagram)的质量可能很差,而且可操作性很差(患者很难根据所提供的信息,确定他们能做什么)。

ChatGPT 3.5是一种人工智能(AI)大型语言模型聊天机器人,它使用2021年4月之前发布的数据中的语言模式,生成对问题的连贯响应。ChatGPT的响应,已被证明与医疗保健提供者的响应,几乎没有区别,从而产生了患者对AI聊天机器人的信任,以获取健康信息。响应存在错误信息的风险,因此,本研究旨在评估ChatGPT对前列腺癌患者问题的响应和健康信息的质量。

研究进展

02

ChatGPT 3.5(https://chat.openai.com/) 被要求生成关于前列腺癌的10个最常问的问题。然后,团队使用谷歌趋势(https://trends.google.com/trends/),进行比较。每个问题,都被输入到ChatGPT中,并生成响应。

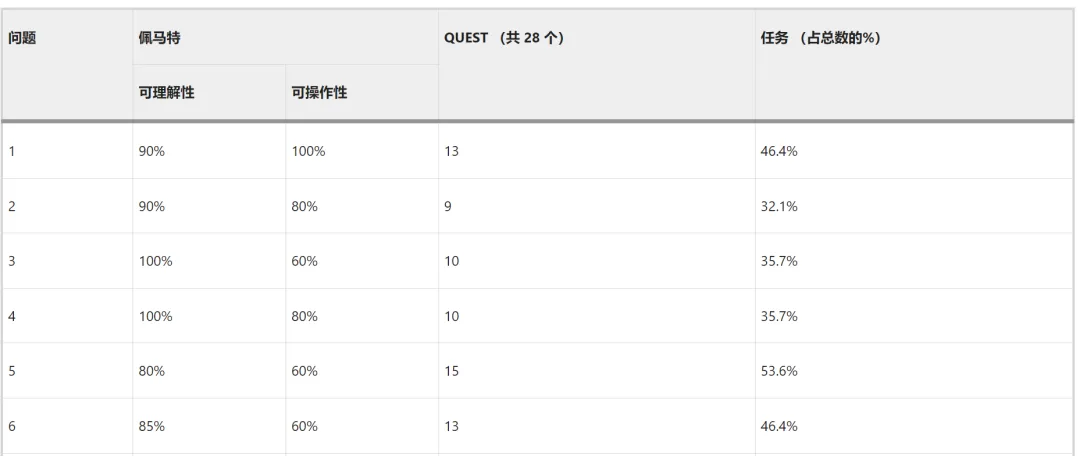

一位经过委员会认证的泌尿科医生,将每个回答,评为“适当”或“不适当”的建议。患者教育材料评估工具(PEMAT),判断内容的可理解性(患者处理和解释关键信息的能力)和可操作性(患者根据所提供的信息,确定他们能做什么的能力),以0-100%进行衡量(高质量需要≥75%)。作者身份、时效性和语气,由QUality评分工具(QUEST)进行评估,满分28分。

ChatGPT生成的大多数(8/10)问题,都在与前列腺癌相关的前25名谷歌搜索中。ChatGPT以可变长度的临床,适当回答了这些问题 [平均206个单词,标准差(SD)50 个单词]。可读性处于大学水平。

1个ChatGPT回答,被认为是高质量的患者教育信息,PEMAT可理解性,平均得分为7.6%(SD 7.76%)。所有回答,都有明确的目的,不包含分散注意力的信息。大多数回答,使用日常语言,以易于理解的方式,呈现医学术语和数字;而1个回答,使用医学术语,但没有相关的医学解释(指BRCA基因突变)。12份回答,使用了要点;7 份回答,缺乏组织特征。有3种回答,会从视觉辅助工具中受益。回答在可操作性方面,平均PEMAT得分为 76%(SD 12.7%)。所有响应,都提供了用户,至少1个可以执行的操作。3个响应,没有明确解释操作;只有1个响应,直接针对用户。

QUEST的信息质量得分较差(平均得分11.3 [40.4%],SD 2 [7.2%])。归因于缺乏作者身份、参考专家来源和时效性指标的信息。所有回答,都使用了谨慎的词汇。其中8项回答,提到了医患关系。

总体而言,ChatGPT生成的回答,与常见的患者查询,相匹配。这表明,人工智能可以成为,通常不确定该问什么的前列腺癌患者的伴侣。

ChatGPT对这些问题的回答,在临床上是合适的,这表明,ChatGPT有可能为患者提供可靠的信息。团队的研究报告显示,ChatGPT对于改编自在线患者资料的前列腺癌问题的回答,其准确率更高(100%)(94.2%)。这表明,ChatGPT本身生成的患者问题,可以得到准确回答。与YouTube、TikTok和Instagram等,以报告重大错误信息而闻名的其他平台相比,ChatGPT可能是一个卓越而准确的在线医疗保健建议平台。然而,QUEST的评估,凸显了ChatGPT的信息透明度,以及与其他研究一致性的问题。包括缺乏作者的身份、参考文献和时效性。 这种透明度的局限性,被谨慎的词汇所抵消,以表明患者固有的医疗不确定性;而这些不确定性,在在线资源中不太明显。

ChatGPT 的回答,是可以理解的,反映了明确目的和日常语言。此外,每个响应,都确定了读者可以采取的1项操作。虽然ChatGPT已被证明,在泌尿肿瘤学领域具有可理解性(66.7%)和可操作性(40%),但团队的研究,显示出更好的可理解性(91.7%)和可操作性(76%),这可能是由于患者需要相对基本的信息。然而,大学水平的可读性,可能并不适用于所有患者。某些响应中,缺乏明确的步骤,可能会影响患者对其健康做出明智决定的能力。缺乏视觉辅助工具,阻碍了其可理解性,这可能会将患者引导至其他平台。例如,TikTok和 Instagram,在这些平台上,更容易遇到错误信息和较差的可操作性。

ChatGPT 生成的回复的内容质量得分(PEMAT 和 QUEST)

研究结论

03

虽然这项研究表明,人工智能在教育和患者信息方面很有前途,但也有明显的局限性,值得人们注意。例如,根据EAU指南,ChatGPT对前列腺癌临床问题的回答中,只有26%是准确的。ChatGPT生成的问题,可能无法完全捕捉到,来自不同背景和心理状态的患者的广度或深度。

此外,ChatGPT没有考虑渐进式信息收集,患者经常通过动态对话,提出其他问题。因此,团队建议,对临床应用进行专业监督,以确保临床的安全性、有效性和可靠性。其次,患者对教育来源和形式的偏好,是更广泛实施的重要考虑因素。60岁以上的患者发现,聊天机器人在认知负荷较低的情况下可用,但其可及性和有效使用,尚不清楚。AI 聊天机器人的版本控制值得考虑,因为ChatGPT 4.0已更新且可定制,但由于付费昂贵而难以访问。目前,团队预计,ChatGPT 3.5将更多地被患者访问,但未来的研究,应不断比较各种AI模型,以获得有效、准确的前列腺癌信息。为特定任务定制AI聊天机器人,为开发专门针对患者需求而量身定制的AI模型,提供了机会。

总之,ChatGPT可以为新诊断的前列腺癌患者,提供可理解的、临床上适当的初步建议。ChatGPT生成的问题,反映了患者通常会问的问题,这对那些不知道该问什么的患者很有帮助。人工智能聊天机器人,可以通过访问医疗保健建议,来增强患者教育。随着人工智能的不断发展,与医疗保健专业人员和医疗数据库的正念集成、持续改进,以及与医疗数据库的协作,对于充分利用其潜力,通过有效的信息传递,为患者赋能至关重要。

腾讯登录

腾讯登录

还没有人评论,赶快抢个沙发